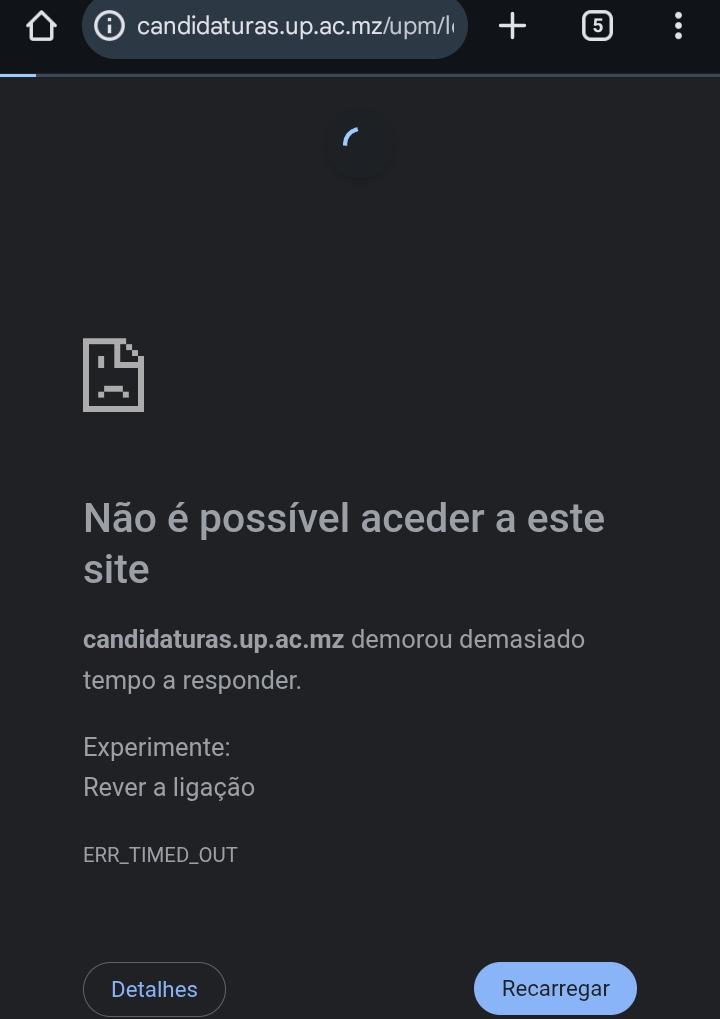

Arquitectura Escalável para Mitigação de Picos Massivos de Acesso em Plataformas de Divulgação Académica

A divulgação de resultados universitários constitui um evento caracterizado por elevada simultaneidade de acessos, com picos abruptos de tráfego concentrados num curto intervalo temporal. Para garantir disponibilidade, integridade e desempenho do sistema, a arquitectura tecnológica deve assentar em três pilares fundamentais: escalabilidade elástica, distribuição eficiente de carga e optimização do processamento no servidor.

1. Infraestrutura e Redimensionamento Dinâmico

Escalabilidade automática (Auto-scaling)

Em ambientes de computação em nuvem, como Amazon Web Services (AWS), Microsoft Azure ou Google Cloud Platform (GCP), recomenda-se a configuração de mecanismos de escalabilidade horizontal automática. Este modelo permite a criação dinâmica de múltiplas instâncias de aplicação quando métricas críticas como utilização de CPU, memória RAM, número de requisições por segundo ou latência ultrapassam limiares previamente definidos.

A escalabilidade horizontal reduz o risco de falha sistémica e garante maior resiliência operacional.

Balanceamento de carga (Load Balancing)

A implementação de um balanceador de carga distribui as requisições HTTP entre múltiplos servidores de aplicação, evitando sobrecarga de um único ponto. Este componente opera com algoritmos como round-robin ou least connections, assegurando distribuição equilibrada e alta disponibilidade.

Rede de Distribuição de Conteúdos (CDN)

A utilização de uma CDN permite a entrega de conteúdos estáticos a partir de servidores geograficamente próximos do utilizador final. Esta abordagem reduz latência, diminui a carga no servidor de origem e aumenta a capacidade de resposta durante picos de acesso.

2. Optimização de Desempenho Aplicacional

Caching em memória

A implementação de sistemas de cache distribuído permite armazenar temporariamente resultados de consultas frequentes à base de dados. Esta técnica reduz o número de operações repetidas, melhora o tempo de resposta e diminui o consumo de recursos computacionais.

Minificação e optimização de activos

A compressão e minificação de ficheiros HTML, CSS e JavaScript reduzem o volume de dados transmitidos ao utilizador. A activação de compressão no servidor web melhora o desempenho e reduz o consumo de largura de banda.

Geração de páginas estáticas

A geração prévia de ficheiros estáticos em formato HTML ou PDF elimina a necessidade de consultas em tempo real à base de dados durante o pico de acesso. O conteúdo pode ser servido directamente pelo servidor web ou por uma CDN, reduzindo significativamente a carga sobre a infraestrutura principal.

3. Gestão e Controlo de Fluxo

Sistema de fila virtual

Sistemas de fila virtual permitem limitar o número de utilizadores que acedem simultaneamente à aplicação. O mecanismo organiza os acessos em fila e liberta o tráfego de forma controlada, conforme a capacidade disponível.

Monitorização em tempo real

A utilização de ferramentas de observabilidade permite monitorizar métricas críticas, incluindo utilização de CPU, latência, throughput e saturação de conexões à base de dados. A detecção precoce de gargalos possibilita intervenção técnica antes da indisponibilidade do serviço.

Conclusão

A mitigação de picos massivos de acesso exige uma arquitectura integrada baseada em elasticidade, redundância e optimização de recursos. A combinação de escalabilidade automática, balanceamento de carga, CDN, caching, geração de conteúdo estático e controlo de fluxo assegura elevada disponibilidade e desempenho consistente durante eventos críticos de grande procura.

Fontes

- AWS Auto Scaling Documentation

- Microsoft Azure Autoscale

- Google Cloud Autoscaling

- AWS Elastic Load Balancing

- NGINX Load Balancing

- Cloudflare – What is a CDN?

- Akamai CDN Overview

- Redis Documentation

- Memcached Documentation

- Google Web Performance Best Practices

- MDN Web Docs

- Cloudflare Waiting Room

- Queue-Fair

- Prometheus Documentation

- Grafana Documentation

- Datadog Monitoring